Farbe in der digitalen Fotografie

Pixel

Bei einem fotochemisch erstellten Bild werden die verschiedenen Graustufen durch unterschiedliche Silbermengen gebildet. Die Feinheit der Struktur, und damit die Größe der kleinsten Bildeinheit, wird durch die ungleichmäßige Anhäufung von Silberpartikeln gebildet. Sollen Bilder in elektronischen Datenverarbeitungsanlagen gespeichert und dort verarbeitet werden, müssen sie zuerst in eine mathematisch erfassbare, numerische Form überführt werden. Im Gegensatz zur nicht definierten Anzahl Bildpunkte bei der fotochemischen Verarbeitung, benötigen elektronisch arbeitende Rechner eine endliche Anzahl geografisch eindeutig indentifizierbarer Bildpunkte, die jeweils in einer ebenfalls endlichen Anzahl Tonwertstufen definiert sind. Die meist quadratischen Bildpunkte (picture elements) bezeichnet man üblicherweise als Pixel. Jedes dieser Bildelemente kann nur aus einem einzigen Helligkeits- bzw. Farbwert bestehen. Sind die Details der Aufnahmeszene feiner als die Größe eines einzelnen Pixels, so besteht der Helligkeits- bzw. Farbwert des Pixels aus der Mischung der im Original an dieser Stelle vorkommenden Helligkeits- und Farbwerte.

Die Welt ist farbig

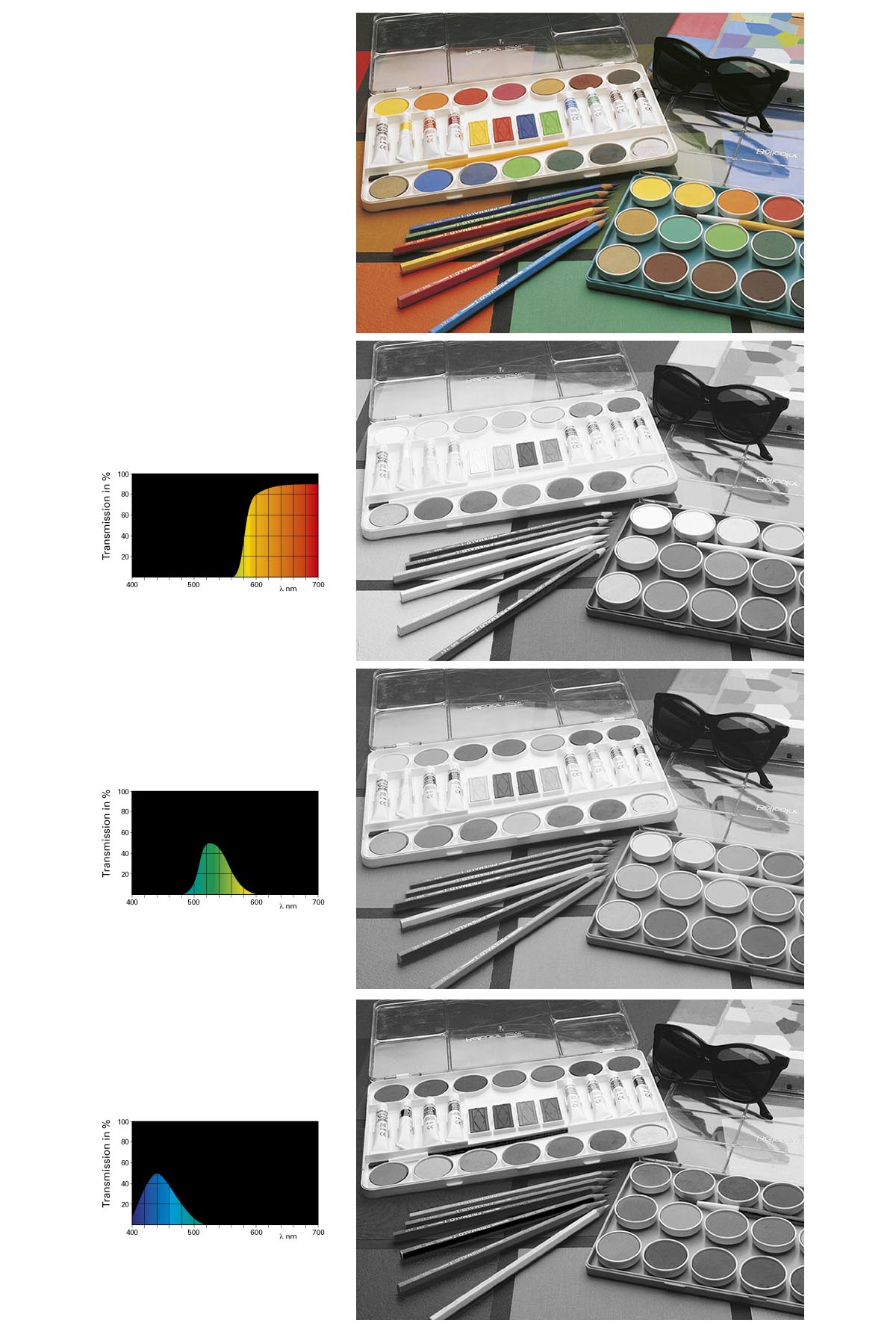

Selbstverständlich ist auch die digitale Fotografie nicht nur monochrom. Der Vorgang der Farberfassung ist sowohl bei der digitalen Direktaufnahme wie beim Scannen derselbe wie in der analogen Fotografie: Jedes Spektraldrittel wird einzeln erfasst. So erhält man bei einer 8-Bit-Codierung je 256 Helligkeitswerte für die Kanäle Rot, Grün und Blau, was zusammen 16’777’216 Farbwerte ergibt. Die 8-Bit-Codes für Rot, Grün und Blau werden dabei einfach aneinandergereiht, wodurch ein 24-Bit-Code als RGB-Signal entsteht. Das Erfassen der Spektraldrittel Rot, Grün und Blau erfolgt dabei durch sogenannte Selektionsfilter (Farbauszugsfilter), welche die Eigenschaft haben, von der farbigen Vorlage nur jeweils den Rot-, Grün- oder Blaubereich durchzulassen und die übrigen Farbwerte zu sperren. Es entsteht ein korrekter Dreifarbenauszug.

Dreifarbenauszug

Der rote Selektionsfilter lässt nur das rote Spektraldrittel passieren. Es entsteht der Rotauszug, dessen Daten (Rot-Kanal) die gesamte Rotinformation des Bildes enthält. Sinngemäß lässt der grüne Selektionsfilter nur das grüne Spektraldrittel passieren; es entsteht der Grünauszug. Der blaue Selektionsfilter ist nur für den blauen Spektraldrittel durchlässig, es entsteht der Blauauszug.

Bei Selektionsfiltern für die direkte Bilderfassung mit einer Kamera müssen sich die Durchlässigkeitsbereiche für die einzelnen Spektraldrittel leicht überlappen. Man verwendet dazu sogenannte Breitbandfilter.

Zeilen- und Flächensensoren

Elektronische Bildempfangssensoren weisen eine sehr hohe Empfindlichkeit auf Rot und Infrarot auf. Um sie auf eine relativ gleichmäßige Empfindlichkeit auf alle Spektraldrittel zu trimmen, werden daher Infrarot-Sperrfilter auf die Sensoren aufgedampft.

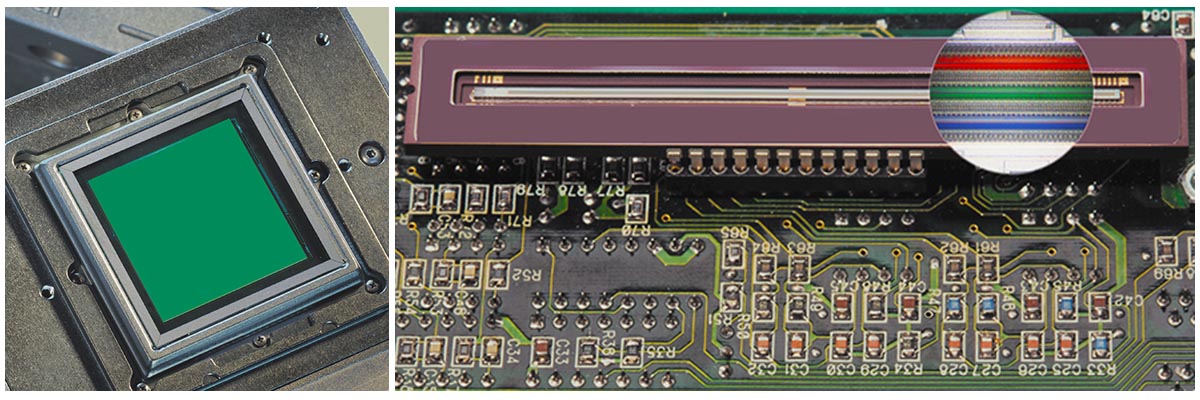

Je nach Empfangsart des optischen Aufnahmesystems unterscheidet man zwischen Zeilen- und Flächensensoren. Bei Scannern wird ein Zeilensensor eingesetzt, mit dem eine Bildvorlage zeilenweise abgetastet wird. Üblicherweise handelt es sich dabei um eine Trilinear-Zeile, das heißt, es sind nebeneinander drei Sensorenzeilen angeordnet, wobei jede Zeile mit dem betreffenden Selektionsfilter ausgerüstet ist. Für Fachkamerazwecke fand ursprünglich auch der Zeilensensor Verwendung (Kamerascanner); dieses Prinzip ist heute jedoch nahezu ausgestorben. Stattdessen setzt man Flächenchips ein, bei denen die einzelnen Sensorelemente als Array über die gesamte Aufnahmefläche verteilt sind.

Flächen- und Zeilensensor

links: Professioneller Flächensensor in einem Digitalback

rechts: Dreifarben-Zeilensensor

Flächenchip-Kameras

Ursprünglich bestanden die Sensoren ausschließlich aus den teuren CCD-Chips. Danach drängten vermehrt Flächenchip-Kameras auf den Markt, welche CMOS-APS enthalten und die bei vergleichbarer Qualität erheblich preisgünstiger sind. Es stellt sich aber zuerst die Frage, wie mittels Flächensensoren – gleichgültig welcher Chip-Grundtyp verwendet wird – schließlich die Farbe aufs Bild gelangt. Im Folgenden diskutieren wir die verschiedenen Möglichkeiten.

One-Pass mit Dreifachmatrix

Ein Flächenchip arbeitet monochrom und kann ohne weitere Manipulation nur für Schwarzweiß-Aufnahmen eingesetzt werden. Die einfachste Lösung ist daher die Dreifarbenkamera, in der das hinter dem Objektiv eintreffende Licht mittels Prismen oder Teilspiegeln in drei Teile zerlegt und jeder Teil auf einen separaten Sensor geworfen wird. Setzt man vor die drei Flächenchips jeweils einen Auszugsfilter Rot, Grün und Blau, entstehen drei digitale Bilder mit der Rot-, Grün- und Blauinformation. Jeder Farbauszug weist dabei die volle Auflösung der verwendeten Pixelmatrix auf.

Mit Kameras in dieser Bauart – ähnlich wie übrigens die sogenannten Drei-Chip-Videokameras – kann bei gleichem Aufnahmelicht gearbeitet werden wie mit herkömmlichem Filmmaterial. Action-Aufnahmen sind bei jeder Verschlusszeit möglich, ebenso das Arbeiten mit Elektronenblitz. Diese Bauart verlangt jedoch drei Chips, was bei größerer Auflösung den Kamerapreis steigert.

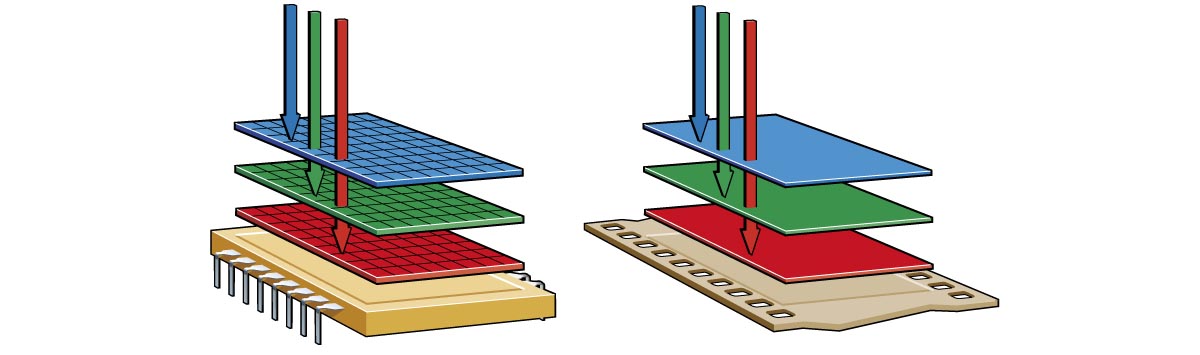

Dreifach-Matrix

links: One-Pass mit Dreifachmatrix

rechts: Three-Pass mit einer Matrix und Filterrad

Three-Pass mit Einfachmatrix

Will man höher auflösende Flächenchips verwenden, scheidet aus preislichen Gründen das One-Pass-Verfahren mit drei CCD-Flächenchips aus. Realisierbar sind Farbaufnahmen durch ein Three-Pass-Verfahren unter Verwendung von nur einer monochromen Matrix. In diesem Fall erfolgt die Bilderfassung mittels drei nacheinander folgenden Aufnahmen durch die jeweiligen Auszugsfilter. Um den Aufnahmevorgang zu automatisieren, verwendet man in der Regel Filterräder. Durch die Auslösung werden dann die drei Farbauszüge nacheinander selbsttätig gemacht. Das Verfahren funktioniert bei jeder Lichtart, mit der auch chemische Aufnahmen gemacht werden können, so auch mit Elektronenblitz; die Blitzanlage wird zur jeweils gegebenen Zeit automatisch ausgelöst.

In der noch jungen Geschichte der Digitalfotografie kamen die beiden beschriebenen Verfahren vor. Heute sind sie jedoch nur noch Geschichte.

One-Pass mit Einfachmatrix und Mosaikfilter

Eine weitere Möglichkeit zur Farbbilderfassung mit nur einem Chip ist durch einen aufgedampften Mosaikfilter möglich. Weil bei diesem Verfahren das Fotografieren mit einem einzigen Schuss genau gleich erfolgt, wie mit herkömmlichem Film (der einzige Unterschied: es wird anstelle des Films ein Mosaikfilterchip verwendet), wird das Prinzip heute ausschließlich verwendet.

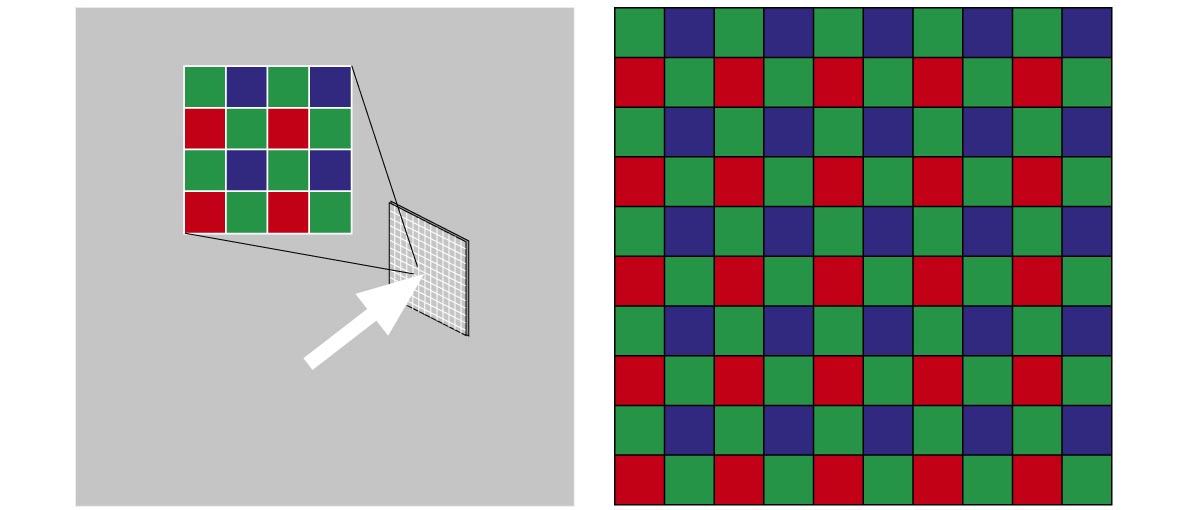

Der Mosaikfilter ist unmittelbar auf dem Schutzglas des CCD- oder CMOS-APS-Flächenchip aufgedampft und zwar so, dass abwechselnd je ein Pixel hinter einem Rot-, Grün- und Blaufilter liegt. Für den einzelnen Pixel bedeutet dies, dass er nur entweder die Rot-, die Grün- oder die Blauinformation registrieren kann. Es liegt auf der Hand, dass sich bei dieser Methode die Auflösung erheblich verringert und die Informationslücken durch Software-Interpolation gefüllt werden müssen, wodurch insbesondere an kontrastreichen Details Farbsäume entstehen können. Eine ganz wesentliche Verbesserung der Bildqualität und eine günstigere Interpolationsmöglichkeit ist zu verzeichnen, wenn der Mosaikfilter doppelt so viele Grünpixel wie Rot- und Blaupixel enthält, indem in den ungeraden Reihen die Filterfarben nur zwischen Grün und Blau abwechseln und in den geraden Reihen zwischen Rot und Grün. Die Grünauszugsfilter dominieren zahlenmäßig, weil man aus der Grüninformation gleichzeitig die Luminanz-(Helligkeits-)Information auch für die benachbarten Blau- und Rotpixel gewinnt.

Bayer-Pattern

Mosaikfilter-Prinzip mit Bayer-Pattern, doppelt soviele Grün- wie Blau- und Rotpixel

Obwohl sich über jedem Pixel nur ein einziger Farbauszugsfilter befindet, ist letztlich die Gesamtauflösung nicht dreimal kleiner. Die bei der späteren Bildübernahme erfolgende Pattern-Verrechnung (Farbinterpolation) sorgt nämlich dafür, dass jeder Pixel auch die Farbinformation aus den anderen Farbkanälen bzw. der Nachbarpixel zugerechnet bekommt. Weil das Verfahren auf die Eigenheiten des menschlichen Sehens Rücksicht nimmt (wir reagieren auf Änderung der Helligkeit bedeutend sensibler als auf Änderungen im Farbwert), ergibt das Verfahren hervorragende Resultate, sofern die einzelnen Pixel bzw. die Pixelabstände nicht zu groß sind.

Trotz der algorithmischen Anpassung an die Begebenheiten des menschlichen Sehens ist die Auflösung letztlich doch etwas geringer als bei einem Three-Pass-System. Bei einzelnen Aufnahmen, welche über dieses System entstehen, können die einen oder anderen Interpolationsfehler auftreten (was jedoch stark von der verwendeten Software und den Rechnungsfähigkeiten des Bildprozessors in der Kamera abhängig ist). Ungeachtet dieser nur selten noch auftretenden Nachteile hat sich das Mosaikfilterprinzip in One-Shot-Kameras aller Preisklassen durchgesetzt.

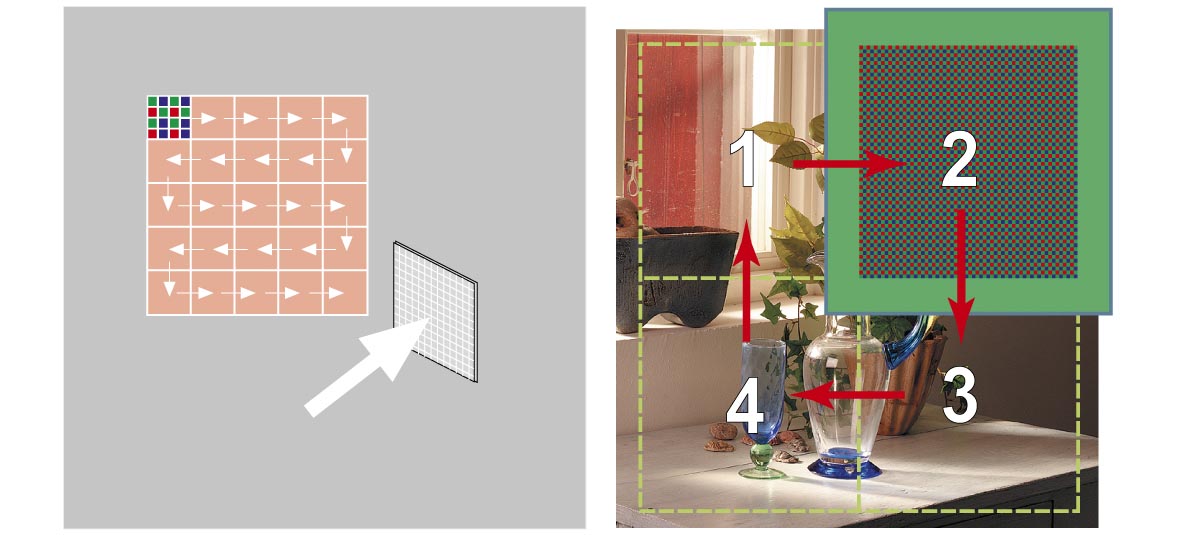

One- und Multi-Shot

Aufgrund der Tatsache, dass trotz Anpassung des Verrechnungs-Algorithmus an die Eigenheiten des menschlichen Sehens das Mosaikfiltersystem eine etwas geringere Auflösung aufweist als ein Three-Shot-System, hat einige Hersteller veranlasst, eine Art historischen Kompromiss einzugehen. Als qualitativ gleichwertige Alternative zum Dreifachmatrixsystem und zum Farbauszugssystem mit drei Durchgängen bleibt die volle Auflösung bei einer Mosaikfiltermatrix bestehen, wenn man ebenfalls mehrmals belichtet und nach jeder Belichtung die Matrix um einen Pixel nach rechts, nach unten und nochmals nach oben verschiebt. Damit jeder Pixel einmal jede Farbe aufnimmt (Grünpixel zweimal), braucht es vier Aufnahmen, aus denen der Prozessor das volle Farbbild mit der umfassenden – echten, nicht interpolierten – Farbinformation zusammensetzt. Da es sich um kleinste Wegstrecken im Mikrometerbereich handelt, ist zum pixelgenauen Verschieben des Bildsensors äußerste Präzision und ein toleranzresistentes System wichtig.

Multi-Shot

Prinzip des Multi-Shots mit einem verschiebbaren Chip

Wie aber erfolgt eine solch präzise Verschiebung? Bei einem System mit Bayer-Pattern sind für den Antrieb zwei Piezoelemente notwendig. Der Chip ist für diese Methode auf einem aus Messing mit höchster Präzision gefertigten Federelement aufgebracht, in dem zwei zueinander senkrecht stehende Piezokristalle die notwendige vertikale und horizontale Verschiebung mit der geforderten extrem hohen Präzision vornehmen.

Mosaikfilterprinzip

links: Piezoelektrische Verschiebung in zwei Richtungen beim Multi-Shot-Verfahren mit Bayer-Pattern.

rechts: Piezoelektrische Verschiebung in einer Richtung mit Linear-Pattern.

Es gibt in der Praxis noch ein weiteres Multi-Shot-System mit Linear-

Pattern, das jedoch weniger präzis arbeitet und erst noch anfällig auf Moiré ist. Bei diesem Linear-Pattern-System sind die einzelnen Filterchen auf dem Mosaikfilter diagonal angeordnet, wodurch ein Multi-Shot mit einem einzigen Piezokristall und der Verschiebung in nur einer Richtung möglich ist.

Microscanning

Eine weitere Variante zur Erhöhung der Auflösung, die den Einsatz von preisgünstigen, geringauflösenden Videochips ermöglicht, ist das Prinzip des Microscannings. Dabei werden mit einem Flächenchip mehrere Aufnahmen nacheinander gemacht und für jede Aufnahme der Chip oder der Lichtstrahl mittels Piezo-Stellgliedern in winzigen Schritten von vielleicht einem µm verschoben. Der einzelne Pixel einer Matrix kann so einige bis viele Male quasi abgescannt werden, woraus eine geringe bis sehr starke Erhöhung der Auflösung sowie der Farbintegrität resultiert. Die jeweils gegeneinander leicht versetzten Teilbilder werden einzeln abgespeichert und anschließend zum Bild mit der entsprechend höheren Auflösung hochgerechnet.

Prinzip des Microscannings

Prinzip des Microscannings

Für die Aufnahme wird hochfrequentes Dauerlicht, vorzugsweise HMI-Licht oder LED benötigt. Ähnlich wie bei Kamerascannern sind dabei die Erfassungszeiten relativ lang, es können aber sehr hohe Auflösungen ohne Interpolation erreicht werden. Durch Auslesen des bei Belichtungsbeginn in erster Stellung erfassten Bildes kann eine sofortige Voransicht auf dem Computermonitor gezeigt werden.

Image-Tiling, Makroscan

Eine vor allem zu Beginn der Digitalfotografie propagierte Methode zur Steigerung der Auflösung geringauflösender CCD-Flächenchips besteht im sogenannten Image-Tiling. Diese Methode funktioniert relativ einfach, sofern zur Aufnahme eine Fachkamera auf dem Prinzip der optischen Bank verwendet wird, welche eine direkte Verschiebung der Bildstandarte zulassen (was bei allen Kameras möglich ist, die auf diesem Bauprinzip beruhen).

Image-Tiling

Erhöhung der Auflösung bei Verwendung eines kleinen Sensors durch Image-Tiling bzw. Makroscan

Beim Image-Tiling wird gewissermaßen das Bild mit entsprechender Überlappung zwei- oder viermal aufgeteilt und jeder Teil mit der vollen Chipauflösung fotografiert. Die Verschiebung muss dabei natürlich absolut parallel erfolgen, was aber mit einer Fachkamera auf dem Prinzip der optischen Bank leicht zu bewerkstelligen ist. Die Teilbilder werden danach mit der Bildbearbeitungs-Software zum Gesamtbild pixelgenau zusammenmontiert, was beispielsweise in Photoshop mit wenigen Mausklicken hochpräzis möglich ist. Diese Methode kann auch bei einzelnen modernen, hochauflösenden Kamerabacks verwendet werden.

Foveon X3 CMOS-Vollfarbsensor

Im Frühjahr 2002 stellte die amerikanische Firma Foveon einen neuartigen CMOS-Bildsensor vor, der ohne Mosaikfilter und ohne Dreifachbelichtung auskommt und trotzdem die volle Dreifarbeninformation liefert. Der Aufbau dieses Chips ist ähnlich wie derjenige eines Farbfilms; es liegen drei verschieden farbempfindliche Schichten übereinander.

Foveon

Der Aufbau des Foveon X3 CMOS-Vollfarbsensors ist vergleichbar mit dem Schichtaufbau eines Farbfilms.

Beim Foveon-Sensor sind die Fotodioden in drei Siliziumschichten eingebettet, welche jeweils für die Grundfarben Rot, Grün und Blau «sensibilisiert» sind. Silizium hat nämlich die Eigenschaft, dass Lichtwellen je nach ihrer Wellenlänge unterschiedlich tief ins Material eindringen. So wird kurzwelliges blaues Licht bereits nahe der Siliziumoberfläche, grünes Licht etwas tiefer und rotes Licht noch weiter unten absorbiert. Die Kunst liegt darin, die Fotodioden der entsprechenden Pixel in den einzelnen Schichten so anzuordnen, dass das nicht absorbierte grüne und rote Licht möglichst ungehindert und mit geringer Streuung in die tiefer liegenden Schichten gelangen kann. Die Tatsache, dass die CMOS-Sensoren für rote Strahlung am höchsten und für blaue Strahlung am wenigsten empfindlich sind, kommt der Forderung nach einem Aufbau in übereinanderliegende Schichten entgegen. Verglichen mit einem herkömmlichen Farbfilm entsprechen die einzelnen Sensoren den übereinanderliegenden Silberhalogenid-Kristallen im chemischen Pendent. Gleich wie beim Farbfilm besitzt somit jeder der drei Farbauszüge die jeweils volle Auflösung.

Foveon X3 Chips wurden in Kameras von Sigma und in der Polaroid x530 verbaut. Sigma hat 2008 den Entwickler Foveon aufgekauft. Eine zur Photokina 2018 angekündigte spiegellose Sigma-Kamera mit einem neu entwickelten Foveon-Kleinbild-Sensor kam indessen nicht auf den Markt, weil Probleme mit dem Sensor aufgetreten sind. Inzwischen ist bekannt, dass die Fertigstellung dieser Kamera vorerst gestoppt wurde. Das Unternehmen hat 2020 mit der Entwicklung des dreilagigen Kleinbild-Sensors nochmals von vorne begonnen.

Text und Abbildungen © by Jost J. Marchesi

Das Kopieren und Weiterverwenden von Text und Abbildungen – auch ausschnittsweise – sind nur mit ausdrücklicher Genehmigung des Autors gestattet.